LLM Format Impact

- Related Project: Private

- Category: Paper Review

- Date: 2024-08-05

Let Me Speak Freely? A Study on the Impact of Format Restrictions on Performance of Large Language Models

- url: https://arxiv.org/abs/2408.02442

- pdf: https://arxiv.org/pdf/2408.02442

- html: https://arxiv.org/html/2408.02442v1

- abstract: Structured generation, the process of producing content in standardized formats like JSON and XML, is widely utilized in real-world applications to extract key output information from large language models (LLMs). This study investigates whether such constraints on generation space impact LLMs’ abilities, including reasoning and domain knowledge comprehension. Specifically, we evaluate LLMs’ performance when restricted to adhere to structured formats versus generating free-form responses across various common tasks. Surprisingly, we observe a significant decline in LLMs’ reasoning abilities under format restrictions. Furthermore, we find that stricter format constraints generally lead to greater performance degradation in reasoning tasks.

TL;DR

- 대규모 언어모델의 표준화된 출력 형식 준수 문제와 그에 대한 구조적 생성 방법 연구

- 수식과 인스트럭션에 따른 포맷 제한이 모델 성능에 미치는 영향에 대한 실증적 실험 분석

- JSON 모드, 포맷 제한 인스트럭션, 자연 언어 전환 등 다양한 방법 비교 연구 및 성능 평가

- 인퍼런스 작업에서는 형식 제한이 적을수록 성능이 향상된다.

- 자연어 응답 > NL-to-Format > 형식 제한 지침(FRI) > JSON 모드

- 엄격한 형식 제한은 LLM의 인퍼런스 능력을 저하시킬 수 있다.

- Classification Task에서는 형식 제한이 오히려 도움이 될 수 있다.

- JSON 모드가 일부 Classification Task에서 더 나은 성능을 보였으며,

- 구조화된 출력이 필요한 Classification Task에서는 엄격한 형식이 정확도를 높일 수 있었다고 합니다.

- 형식 제한의 유연성이 필요

- 스키마 제한을 제거하고 형식만 지정하는 것이 성능과 일관성을 향상시켰다고 보고하며,

- 복잡한 인퍼런스 작업에서는 느슨한 형식 제한이 LLM의 능력을 보존하면서도 구조화된 출력 확인했다고 합니다.

작업의 특성에 따라 적절한 형식 제한 수준을 선택하는 것이 모델 성능에 영향을 미칠 수 있으며, 인퍼런스 작업에서는 자유로운 형식이, Classification Task에서는 구조화된 형식이 더 효과적일 수 있으며, 일반적으로는 유연한 형식 제한(느슨한 제한)이 LLM의 성능을 최적화하는 데 도움이 될 수 있다고 보고합니다.

올해 LLM을 사용한 짧은 프로젝트인 Open Interview(경력 기술서 등을 넣고, 인터뷰 질의 응답 등 인터뷰 준비를 위한 문서를 생성해주는 간단한 파이썬 코드)를 짜면서 간단한 프롬프트 엔지니어링을 했는데, 형식적인 포맷에 대한 성능 차이를 확인했었는데 아웃풋 포맷에 일정한 key에 value로 리턴하는 것에는 큰 영향이 없었으나, 완전 구조화 된 포맷(XML, JSON)을 인풋으로 넣어주는 것에 대해서는 약간의 성능 차이를 관찰했고, 특히 리턴되는 포맷을 정형화하는 것도 구조가 복잡해질수록 성능 저하를 관찰할 수 있었습니다.

1 서론

대규모 언어모델(LLM)의 인컨텍스트 학습과 명령 따르기 능력은 이들이 downstream 작업을 해결하는 데 즉시 사용될 수 있도록 하였습니다. 그러나 LLM을 산업 애플리케이션에 통합하는 주요 장애물 중 하나는 표준화된 출력 형식을 준수하지 않는 것입니다. 이런 일관성 없는 출력은 파싱을 복잡하게 만들고 모델의 신뢰성을 저하시킵니다. 이 문제를 극복하기 위한 일반적인 접근 방법은 구조화된 생성으로, JSON이나 XML과 같은 표준화된 형식으로 출력을 제공하는 것을 포함합니다. 이런 제한은 여러가지 방식으로 구현될 수 있으며, 이는 LLM의 실제 애플리케이션 통합을 간소화합니다. 본 연구에서는 포맷 제한 인스트럭션가 LLM의 생성된 내용의 품질에 미치는 영향을 광범위한 과제에서 실증적 실험을 통해 분석합니다. 이는 포맷 제한 인스트럭션와 생성된 내용의 품질 간의 관계를 체계적으로 조사한 최초의 연구입니다.

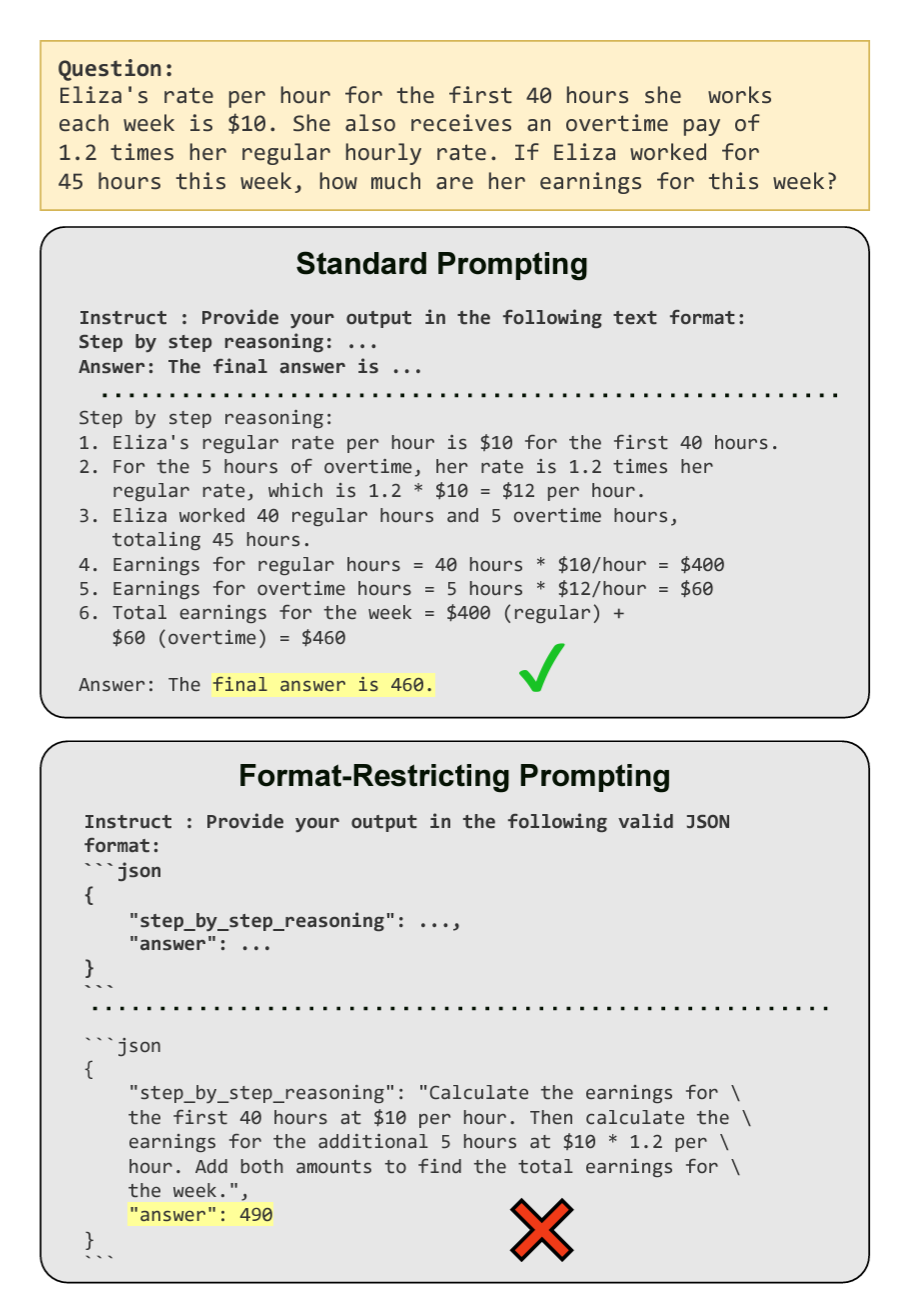

Figure 1:GPT-3.5-turbo prompted with GSM8K math questions in standard natural language answered correctly, but failed when format restrictions were applied.

2 방법

구조화된 생성을 위한 방법으로는 다음과 같은 세 가지 방법을 실험에 사용합니다.

- 제약된 디코딩 (JSON 모드): 이 방식은 생성 과정 중 사전 정의된 토큰 공간을 강제하여 LLM의 출력을 제한합니다. 이 모드는 유효한 JSON 출력을 보장하며, 주로 산업 환경에서 광범위하게 사용됩니다.

- 포맷 제한 인스트럭션 (FRI): LLM에게 지정된 스키마를 준수하여 표준화된 포맷으로 응답을 생성하도록 인스트럭션합니다. 이 방법은 생성된 출력이 구조화된 형식을 따르도록 하여 최종 답변의 추출과 평가를 용이하게 합니다.

- 자연 언어에서 포맷으로 (NL-to-Format): 이 두 단계 과정은 먼저 자연 언어로 질문에 대한 답을 하도록 인스트럭션한 다음, 그 응답을 목표 포맷 스키마로 변환하도록 합니다. 이는 내용 생성에서 포맷 준수를 분리하는 가장 느슨한 버전의 구조화된 생성 방법입니다.

3 실험

3.1 데이터셋

다양한 도메인에서 수집된 데이터셋을 사용하였으며, 주로 다음과 같은 두 가지 유형의 작업으로 구분됩니다.

- 인퍼런스 태스크

- GSM8K: 일상 생활 시나리오를 반영한 자연 언어 맥락에서 설정된 수학 문제 모음으로 LLM이 필요한 중간 인퍼런스 단계를 생성하도록 요구

- Last Letter Concatenation: 문자열을 생성하기 위해 단어 시퀀스의 마지막 글자를 연결하는 것을 요구하는 작업으로, 상징적 인퍼런스 능력을 시험

- Shuffled Objects: 초기 상태와 물체의 섞임 시퀀스가 주어진 상태에서 최종 상태를 인퍼런스하는 능력을 평가

- Classification Task

- DDXPlus: 환자 프로필에 기반하여 가장 적절한 진단을 선택해야 하는 다중 선택 의학 진단 데이터셋

- MultiFin: 주어진 단락을 다섯 가지 범주 중 하나로 분류해야 하는 다중 선택 금융 데이터셋

- Sports Understanding: 스포츠와 관련된 인공적으로 구성된 문장이 타당한지 여부를 판단하는 작업

- NI - Task 280: 주어진 단락에 기반한 다중 선택 스테레오타입 Classification Task

3.3 평가 방법

모델의 성능을 평가하기 위해 작업별로 특화된 평가 지표를 사용합니다. 분류 기반 작업에는 주로 정확도를 사용하며, Last Letter Concatenation 및 GSM8K에는 최종 답변이 실제 답과 정확히 일치해야 하는 정확한 매치 지표를 사용합니다.

4 주요 결과

4.1 포맷 제한이 최종 결과에 미치는 영향

포맷 제한의 정도와 구현이 LLM의 성능에 상당한 영향을 미칠 수 있음을 발견하였습니다.

특히 인퍼런스 태스크에서는 구조화된 출력의 키 순서와 인퍼런스에서 포맷 준수의 분리가 LLM 기능을 유지하는 데 중요한 요소로 작용합니다.

분류 데이터셋을 평가할 때는 인퍼런스 태스크과는 다른 경향이 관찰되었으며, 특히 DDXPlus 데이터셋에서 JSON 모드가 활성화되었을 때 성능이 크게 향상되는 것을 확인하였습니다. 이런 결과는 포맷 제한의 영향이 작업 종속적일 수 있음을 시사하며, 엄격한 포맷은 인퍼런스 중심의 작업을 방해할 수 있지만, 구조화된 출력이 요구되는 Classification Task의 정확성을 향상시킬 수 있습니다.

분류 데이터셋 - JSON 성능이 더 좋았다.

5 논의

5.1 느슨한 포맷 제한의 영향

포맷 제한의 영향을 추가적으로 조사하기 위해 스키마 제한을 제거한 소프트 제한 설정을 살펴봤습니다. 특정 스키마를 제공하는 대신 (e.g., “다음 스키마를 사용하여 JSON 형식으로 답변하세요: { “reason”: …, “answer”: … }”), 단순히 타깃 포맷 언어로 출력하도록 LLM에 인스트럭션합니다 (e.g., “JSON 형식으로 답변하세요.”).

표 1은 GSM8K 데이터셋에서 스키마 제한을 제거했을 때의 영향을 보여줍니다. Claude 3 Haiku, GPT-3.5 Turbo, LLaMA 3 8B Instruct에서 다른 프롬프트 변형에 대해 평균 점수가 상당히 향상되고 표준 편차가 낮아진 것을 관찰할 수 있습니다. 이 결과는 구조화된 출력이 downstream 처리에 유리할 수 있지만, 지나치게 제한적인 스키마는 특히 인퍼런스 중심의 작업에서 LLM의 성능을 저해할 수 있음을 시사합니다.

이런 발견은 쉽게 파싱할 수 있는 구조화된 출력과 LLM의 본질적인 인퍼런스 능력을 보존할 필요성 사이의 균형이 필요함을 제안합니다. 실무자들은 복잡한 인퍼런스 태스크을 다룰 때 느슨한 포맷 제한을 고려하면서도 downstream 처리를 용이하게 할 수 있는 일정 수준의 구조를 유지할 것을 고려해야 합니다.

| 모델 | 텍스트 | JSON | XML | YAML |

|---|---|---|---|---|

| gemini-1.5-flash | 89.33 | 89.66 | 89.26 | 89.21 |

| (표준 편차) | (0.8) | (0.3) | (0.3) | (0.4) |

| + 스키마 제약 | - | 89.21 | 88.20 | 87.42 |

| - | - | (1.5) | (2.2) | (3.7) |

| claude-3-haiku | 86.51 | 86.99 | 86.96 | 82.89 |

| (표준 편차) | (0.8) | (0.2) | (0.6) | (5.7) |

| + 스키마 제약 | - | 23.44 | 79.76 | 80.63 |

| - | - | (22.9) | (7.0) | (2.8) |

| gpt-3.5-turbo | 75.99 | 74.70 | 60.45 | 71.58 |

| (표준 편차) | (3.1) | (1.1) | (7.2) | (3.0) |

| + 스키마 제약 | - | 49.25 | 45.06 | 73.85 |

| - | - | (12.0) | (19.9) | (5.6) |

| LLaMA-3-8B | 75.13 | 64.67 | 65.07 | 69.41 |

| (표준 편차) | (0.9) | (2.23) | (0.56) | (0.95) |

| + 스키마 제약 | - | 48.90 | 56.74 | 46.08 |

| - | - | (6.7) | (8.3) | (16.8) |

표 1: 스키마 제약의 유무에 따른 결과 비교, 스키마를 추가하면 프롬프트에 대한 민감도가 증가하고 평균 성능이 저하됨.

5.2 다양한 포맷의 비교

이 절에서는 JSON뿐만 아니라 XML 및 YAML 포맷도 비교합니다. 세 가지 언어는 각기 다른 문법 구문 규칙과 제약을 가지고 있으므로, 각 모델은 예를 들어 Claude-3-Haiku가 XML을 도구 사용 스키마로 사용하는 것처럼, 서로 다르게 수행될 수 있습니다.

표 8에서 Classification Task에서 JSON 모드가 텍스트보다 훨씬 더 나은 성능을 보였지만, 인퍼런스 관련 작업에서는 인퍼런스를 먼저 수행한 후 답변을 제공해야 하는 순서를 따르지 못해 최종 성능이 크게 떨어진 것을 발견했습니다.

5.3 구조 포맷 및 파싱 오류율

처음에는 텍스트와 구조화된 포맷 간의 성능 격차가 답변 추출 중 파싱 오류로 인해 발생할 수 있을 것으로 가정했습니다. 그러나 표 2에서 보듯이, 다양한 포맷과 모델 간의 오류율 분석 결과 이는 주된 요인이 아님을 밝혀냈습니다. 사실, Gemini 1.5 Flash와 GPT 3.5 Turbo는 세 가지 포맷 모두에서 거의 영 파싱 실패를 보여줍니다. LLaMA 3 8B 설정에서는 JSON 포맷의 Last Letter 작업에서 파싱 오류율이 단 0.148%에 불과하지만, 표 1에서 보듯이 38.15%의 상당한 성능 격차가 존재합니다.

이 발견은 포맷 간 성능 차이가 주로 파싱 오류 때문이 아니라 포맷 제한이 LLM의 인퍼런스 및 생성 과정에 미치는 영향 때문임을 시사합니다. 그러나 발견된 파싱 오류는 간단한 수정 단계를 통해 효과적으로 완화될 수 있습니다.

Claude-3-Haiku를 파싱 오류가 있는 출력을 재형식화하도록 프롬프트하여 Claude 3 Haiku 및 LLaMA 3 8B(파싱 오류 비율이 가장 높은 두 모델)의 JSON 및 YAML 포맷에서 점수가 향상된 것을 Figure 5에서 보여줍니다. 이 접근 방식은 포맷별 최적화의 이점을 희생하지 않으면서 구조화된 출력의 신뢰성을 향상시킬 수 있는 가능성을 보여줍니다.

6 관련 연구

본 논문의 핵심인 (1) LLM의 인퍼런스 능력과 (2) 포맷 따르기 능력와 관련된 선행연구를 살펴봅니다.

(1) LLM의 인퍼런스 능력에 대한 초기 연구에서 Kojima et al. (2022)은 “단계별로 생각하기”를 사용하여 몇 가지 예제 없이도 인퍼런스 능력을 유도할 수 있음을 발견했습니다. 이후 연구(Jin et al., 2024)는 인퍼런스 단계 수가 최종 정확도와 연관이 있음을 보여줍니다. 최근 연구(Wang and Zhou, 2024)는 Chain-of-Thought(CoT) 인퍼런스 씨드 프롬프트 Kojima et al. (2022)를 조심스럽게 고안된 CoT 디코딩 스키마로 제거할 수 있음을 발견했습니다.

(2) LLM의 인스트럭션 따르기 및 지정된 포맷으로 응답 생성 능력 탐구는 처음으로 IFEval Zhou et al. (2023)에 의해 다루어졌으며, 일반 인스트럭션 따르기 능력을 평가하기 위해 설계되었고 특히 포맷 따르기를 평가하는 테스트 인스턴스의 하위 집합을 포함합니다. INFOBENCH Qin et al. (2024)은 인스트럭션를 다양한 범주로 세분화하여 더 세밀한 분석을 수행합니다. FOFO Xia et al. (2024)은 LLM의 포맷 따르기 능력에만 초점을 맞춘 벤치마크입니다. 그러나 이런 연구들은 포맷 인스트럭션가 downstream 성능에 간섭을 주는지에 대해서는 탐구하지 않습니다.